KI-Agenten sind die nächste Evolutionsstufe der Künstlichen Intelligenz.

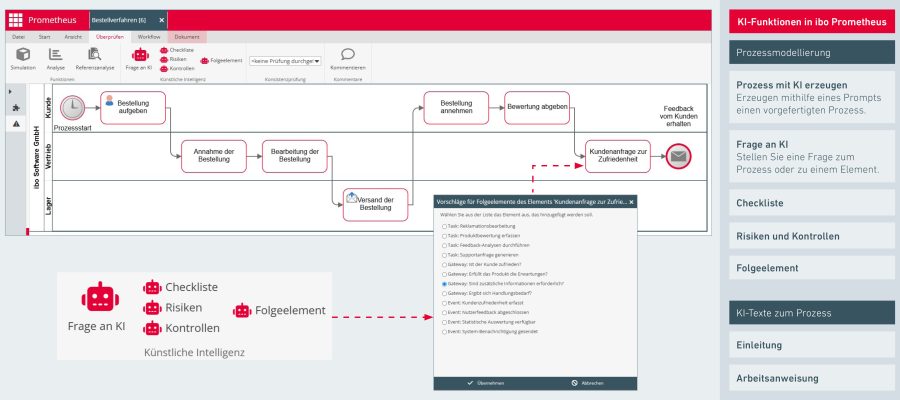

In der Prozessmodellierung ermöglichen sie automatisierte, lernfähige und sich selbst optimierende Abläufe – von der Modellierung über die Analyse bis zur Compliance.

Sind Sie bereit für die Arbeitswelt von morgen? Hier finden Sie Themen rund um die Digitalisierung, neue Arbeitsweisen und Herausforderungen. Gemeinsam machen wir Sie und Ihr Unternehmen fit für die Arbeitswelt von morgen.

KI-Agenten sind die nächste Evolutionsstufe der Künstlichen Intelligenz.

In der Prozessmodellierung ermöglichen sie automatisierte, lernfähige und sich selbst optimierende Abläufe – von der Modellierung über die Analyse bis zur Compliance.

Agenten sind das neue Schlagwort der KI-Welt. Ob als Copilot, digitaler Assistent oder autonomes System – überall entstehen Programme, die selbstständig Aufgaben übernehmen. Von außen ist oft kaum zu erkennen, welche Komplexität sich hinter dem Begriff „KI-Helfer“ verbirgt – denn alles heißt derzeit Agent. Dahinter können winzige, auf eine einzelne

Die Umsetzung der ESG-Kriterien ist längst Pflicht – nicht nur für Konzerne, sondern auch für Zulieferer, Partner und mittelständische Unternehmen. Sie dienen als Maßstab für nachhaltige Unternehmensführung. Wer heute Projekte ohne ESG-Bewertung startet, läuft Gefahr, an Investoren und Kunden vorbeizuplanen. In diesem Artikel beleuchten wir die ESG-Kriterien, ihre Bedeutung und die Rolle von Projektmanager:innen bei der Erfassung und Aufbereitung von projektbezogenen Daten im Projektportfolio für Nachhaltigkeitsberichte mit einer geeigneten Software.

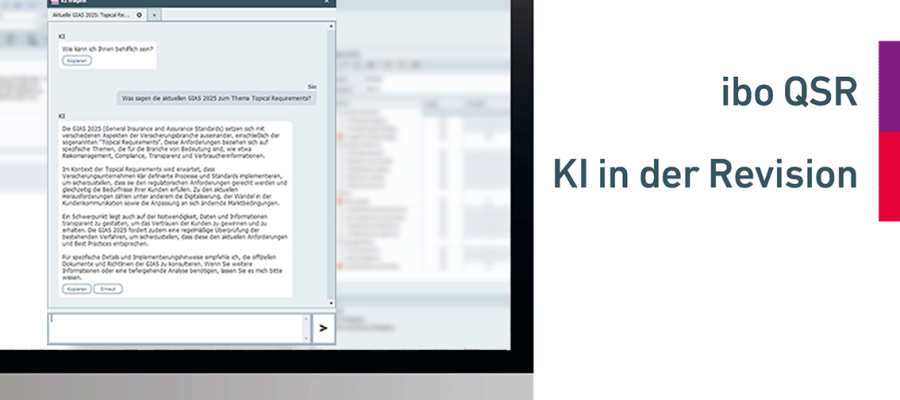

Viele Unternehmen stehen unter dem Leistungsdruck ihre Prüfungs- und Compliance-Prozesse effizienter und transparenter gestalten. KI bietet hier innovative Lösungen, doch die Reaktionen sind zögerlich. In diesem Artikel geht es um DSGVO-konforme Anwendung und Ermöglichung von KI in einer Revisionssoftware, Herausforderungen, Risiken und die Erfüllung der datenschutzrechtliche Anforderungen.

Verwaltungen stehen heute vor vielfältigen Herausforderungen, die Fortschritte oft erschweren und Prozesse ins Stocken bringen. In diesem Beitrag erfahren Sie, warum Effizienzsteigerungen häufig an isolierten Maßnahmen scheitern und welche nachhaltigen Erfolge durch einen ganzheitlichen, systemischen Ansatz erzielt werden können. Wir zeigen Ihnen praxisnah, wie Sie Organisation, Personal und Prozesse in der Verwaltungsdigitalisierung verzahnen, um spürbare Verbesserungen zu erreichen.

Die Lernfähigkeit ist ein wichtiger Faktor, um die Basis für eine Wettbewerbsfähigkeit zu schaffen. Damit man lernfähig bleiben kann, wird ein wirkungsvolles Schnittstellenmanagement benötigt. Aber welche Rahmenbedingungen braucht es, um Prozesse stetig weiterentwickeln und verbessern zu können? Wir zeigen Ihnen, warum Sie auch die Schnittstellenkompetenz im Prozessmanagement Ihrer Organisation fördern

Prozessbeschreibungen, Dokumentationen, Aufgaben und Übersichten sind wichtige Instrumente für Prozessbeauftragte, um die Unternehmensabläufe zu modellieren. Doch auch die Transparenz und die Detailtiefe spielen darin eine wichtige Rolle, wenn man reibungslose und effiziente Prozesse erstellen möchte. Wir zeigen Ihnen, mit welchen Mitteln adressatengerechte Prozesse erstellt und alle Prozessbeteiligten mitgenommen werden. Klarheit

Prozessmanagement lebt nicht von Handbüchern, sondern von Menschen, die ihr Wissen teilen, voneinander lernen und gemeinsam Lösungen finden. Der Beitrag zeigt, warum Lernen im Dialog entsteht, welche Rolle Communities dabei spielen und wie die ibo Community Prozessmanagement Fachwissen in echte Handlungskompetenz verwandelt.

Steuern Sie Maßnahmen zentral in einer Plattform. ibo Audit Follow-up entlastet Sie. Weniger E-Mails, klare Zuständigkeiten, Live Status, Nachweise im Kontext. Für Revision, Compliance, Datenschutz, Informationssicherheit, QM und Validierung. Binden Sie Kollegen ein, klären Sie Fragen direkt und schließen Sie schneller ab.

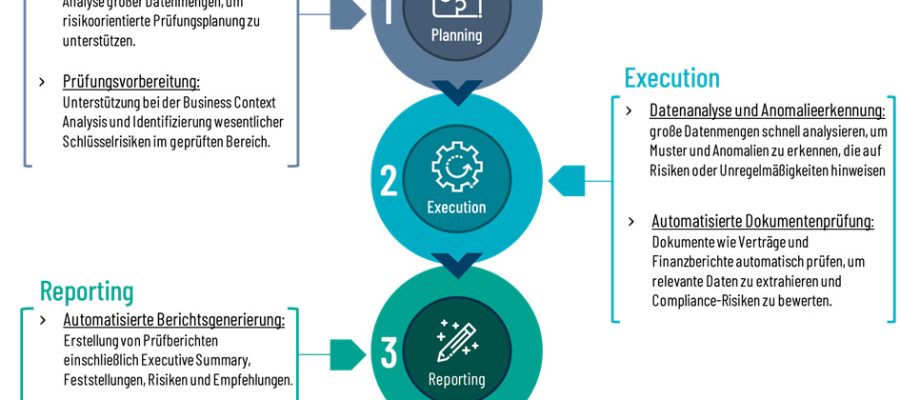

Wie KI, Data Analytics und Automatisierung die Interne Revision verändern: weg von Stichproben, hin zu kontinuierlichem Monitoring, proaktiver Risikosteuerung und digitaler Strategie.

Sie balancieren wachsende Kundenansprüche, dichte Regulierung, knappe Ressourcen. Projekte stauen sich, Rollen bleiben unklar, Nachweise kosten Zeit. Dieser Beitrag führt Sie systematisch durch die fünf zentralen Baustellen und zeigt, wie Sie mit der ibo-Toolbox sofort ansetzen.

Wie gelingt Projektmanagement wirklich? Am ibo Praxistag Projektmanagement 2025 erleben Sie echte Praxisberichte, Austausch mit Branchenexperten und KI-basierte Tools. Ob öffentliche Verwaltung, Bank oder Stiftung, hier bekommen Sie praxistaugliche Lösungen statt Theorie.

Prompt Injection ist das Einfallstor für Hacker, wenn KI-Features ungeschützt bleiben. Der Beitrag zeigt praxisnah, wie Angreifer Prompts manipulieren, welche Schwachstellen sie ausnutzen und mit welchen Sicherheitsmaßnahmen Sie Ihr LLM vor Jailbreaks und Datenlecks schützen.

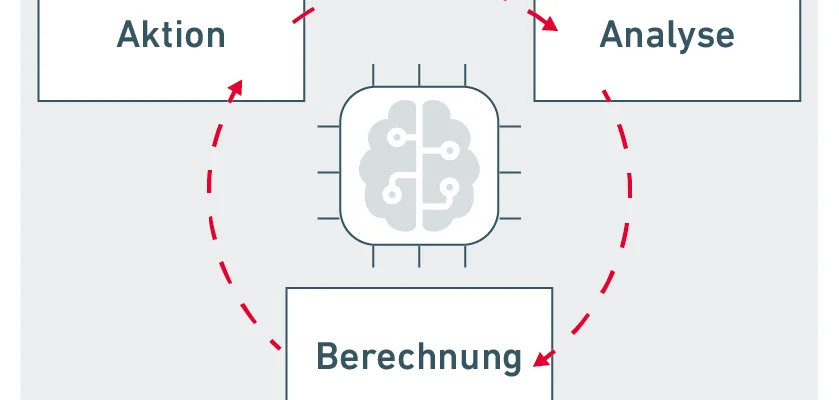

KI braucht Konnektivität: Nur wenn ERP, CRM & Co. nahtlos integriert sind, entfaltet KI-gestützte Prozessautomatisierung ihr volles Potenzial. Der Beitrag zeigt, wie BPMN-Orchestrierung und autonome Agenten Abläufe beschleunigen und Compliance sichern.

Künstliche Intelligenz kann mehr als automatisieren: Sie ist der Impulsgeber für Lernen, Innovation und menschenzentrierte Organisationsentwicklung. Der Artikel zeigt, wie Unternehmen mit Intent-Story, Use-Cases, Dual Scorecard und Ethik-Retros zur lernenden Organisation werden – praxisnah, reflektiert und zukunftsorientiert.

Sie möchten Geschäftsprozesse schneller und einfacher modellieren? ibo Prometheus unterstützt Sie ab sofort mit integrierter KI: Prozesse automatisch erstellen, Risiken erkennen und Workflows effizient optimieren. Erfahren Sie, wie Sie direkt profitieren!

Wie sieht eigentlich die Zukunft der Internen Revision hinsichtlich KI aus? Kann KI uns helfen, Revisionsprozesse zu verbessern? Die Interne Revision ist im Wandel und KI ist schon heute in Benutzung, um bei Prozessen in vielerlei Hinsicht zu unterstützen.

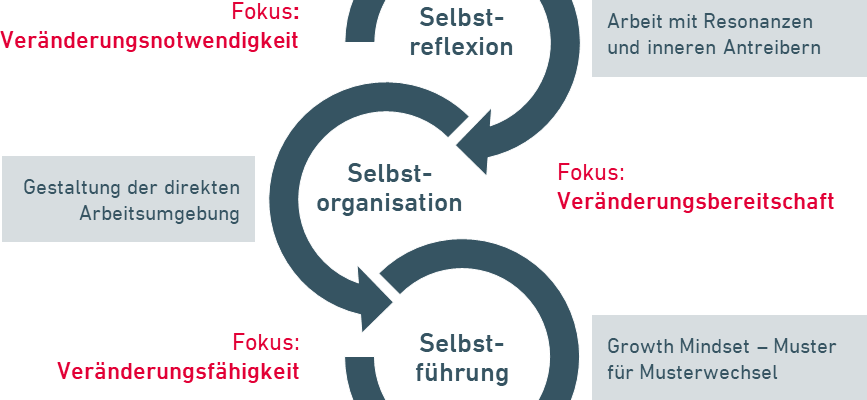

Was bremst den Fortschritt in Unternehmen? Warum haben auch Führungskräfte Angst vor Veränderungen? Claudia Weiß, Ansprechpartnerin für Inhouse-Kunden, argumentiert, was die Personalentwicklung konkret tun kann, um Führungskräfteentwicklung zu fördern.

Innovations- und Veränderungsfähigkeit gelten als Treiber für Wettbewerbsstärke, Resilienz und Zukunftsfähigkeit. Doch bleiben konkrete Umsetzungsschritte in der Organisation oft diffus. Damit das Neue bzw. Innovation aber kein Zufall bleibt, braucht es eine Ideenkultur, die strukturell getragen wird. Christian Konz zeigt auf, warum Struktur und Kultur gemeinsam gedacht und gestaltet werden müssen.

Wie lassen sich MaRisk-Anforderungen sicher und nachvollziehbar im Projektalltag umsetzen? ibo netProject unterstützt Projektmanager:innen in Finanzinstituten bei der Einhaltung regulatorischer Vorgaben – mit klaren Rollen, transparenter Dokumentation und einer Schnittstelle für die Benutzerverwaltung.